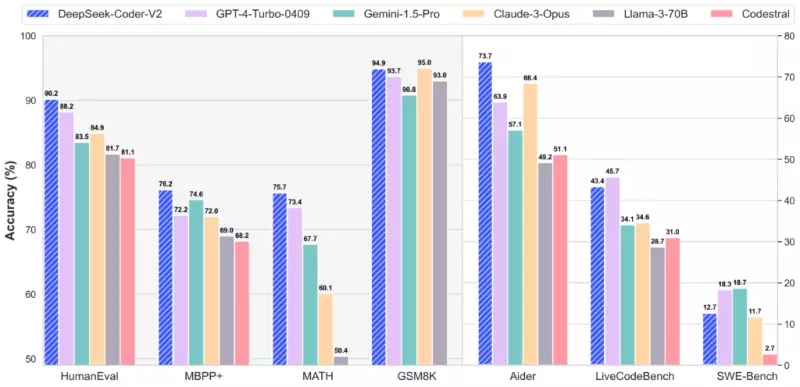

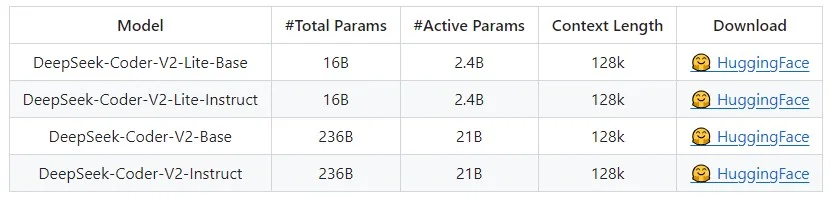

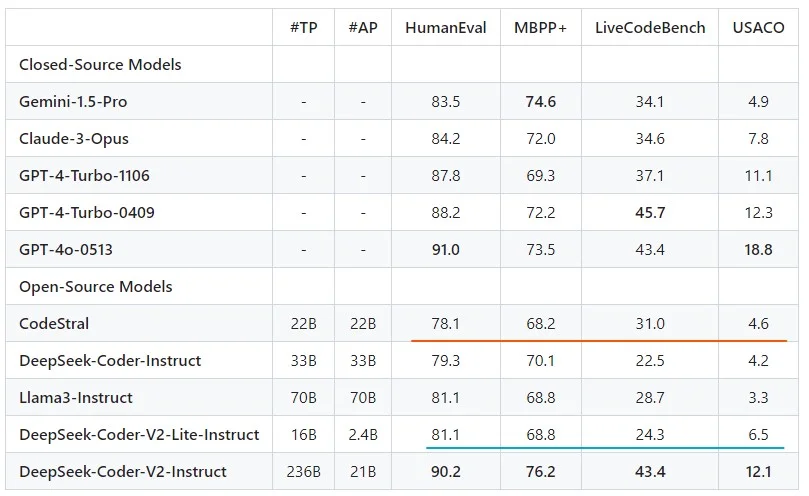

DeepSeek, слідом за своєю моделлю DeepSeek-V2, представила модель, що спеціалізується на коді DeepSeek-Coder-V2. Модель представлена у двох видах: DeepSeek-Coder-V2 розміром 236B і DeepSeek-Coder-V2-Lite розміром 16B. Старша модель у більшості представлених бенчмарків обходить платних конкурентів.

DeepSeek-Coder-V2 – побудована на архітектурі MoE (Mixture-of-Experts), що означає, що в момент інференсу активною є тільки частина ваги (2.4B і 21B відповідно для старшої та молодшої моделі), що прискорює генерацію. Розмір контексту 128k.

Молодша модель на 16B (активних параметрів 2.4B) за деякими бенчмарками обходить Codestral 22B, яка є найкращою середньо-малою моделлю для генерації коду, що робить нову модель доволі цікавою для тестування як локального copilot.

Для запуску як локального copilot можна скористатися continue або codegpt – обидва проєкти вміють запускатися на локальних моделях і, крім доповнення коду, надають інтерфейс для аналізу, рефакторінгу, переписування і доопрацювання коду.