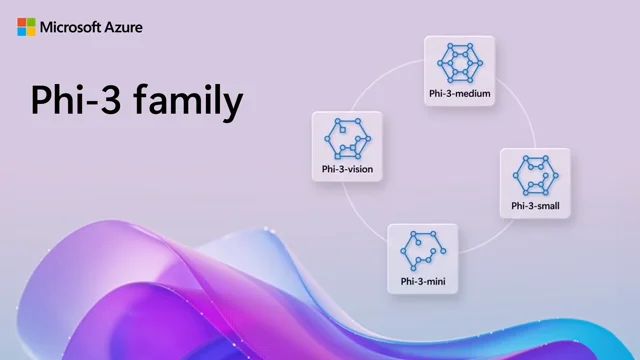

Microsoft випустила сімейство моделей штучного інтелекту Phi-3,5, яка включає Phi-3.5-vision, Phi-3,5-MoE і Phi-3.5-mini. Усі вони побудовані на основі синтетичних даних і відфільтрованих загальнодоступних сайтів. Лінійка ШІ-моделей підтримує контекст довжиною 128 тис. токенів. Три моделі доступні на платформі Hugging Face за ліцензією MIT.

Phi-3.5-MoE примітна використанням технології Mixture of Experts (MoE). За такого підходу тільки частина мережі використовується для обчислення вихідних даних для будь-якого одного входу. Модель із 16 групами та 3,8 млрд параметрів використовує 6,6 млрд параметрів, вона навчена на 4,9 трлн токенів із застосуванням 512 графічних процесорів Nvidia H100.

Дослідницька група Microsoft розробила модель з нуля, щоб підвищити її продуктивність. У стандартних ШІ-тестах Phi-3.5-MoE перевершує Llama-3.1 8B, Gemma-2-9B і Gemini-1.5-Flash, а також вона близька до лідируючої GPT-4o-mini.

Phi-3.5-mini c 3,8 млрд параметрів випереджає Llama-3.1 8B і Mistral 7B, а також здатна скласти конкуренцію Mistral NeMo 12B. ШІ-модель навчили на 3,4 трлн токенів із використанням 512 одиниць H100. Microsoft представила малу модель ще у квітні цього року.

Маючи всього 3,8 млрд активних параметрів, Phi-3.5-mini є конкурентоспроможною в багатомовних завданнях порівняно з великими мовними моделями з набагато більшою кількістю параметрів. Крім того, модель тепер підтримує довжину контексту 128 тис. токенів, а її головний конкурент, Gemma-2, тільки 8 тис.

Phi-3.5-vision – це модель із 4,2 млрд параметрів, навчена на 500 млрд токенів із застосуванням 256 графічних процесорів Nvidia A100. Вона підтримує аналіз багатофреймових зображень і міркування. Модель поліпшила продуктивність у MMMU з 40,2 до 43, у MMBench з 80,5 до 81,9, у TextVQA з 70,9 до 72.