Після випуску DeepSeek-R1 у Китаї з’явилася ще одна модель логічного мислення. Нова мультимодальна модель Kimi k1.5 від Moonshot AI показує вражаючі результати порівняно з визнаними моделями AI в складних завданнях логічного мислення.

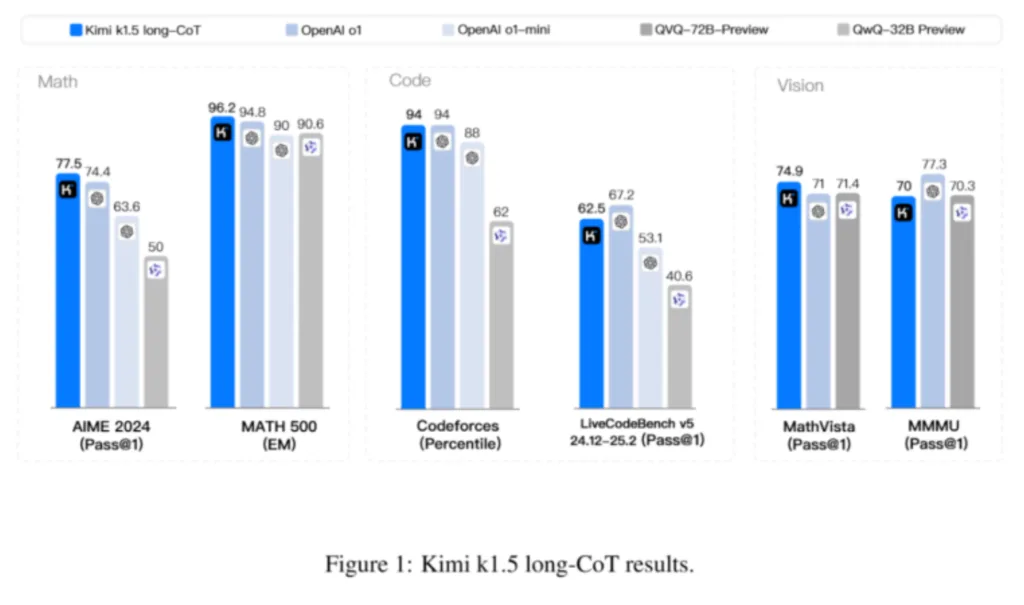

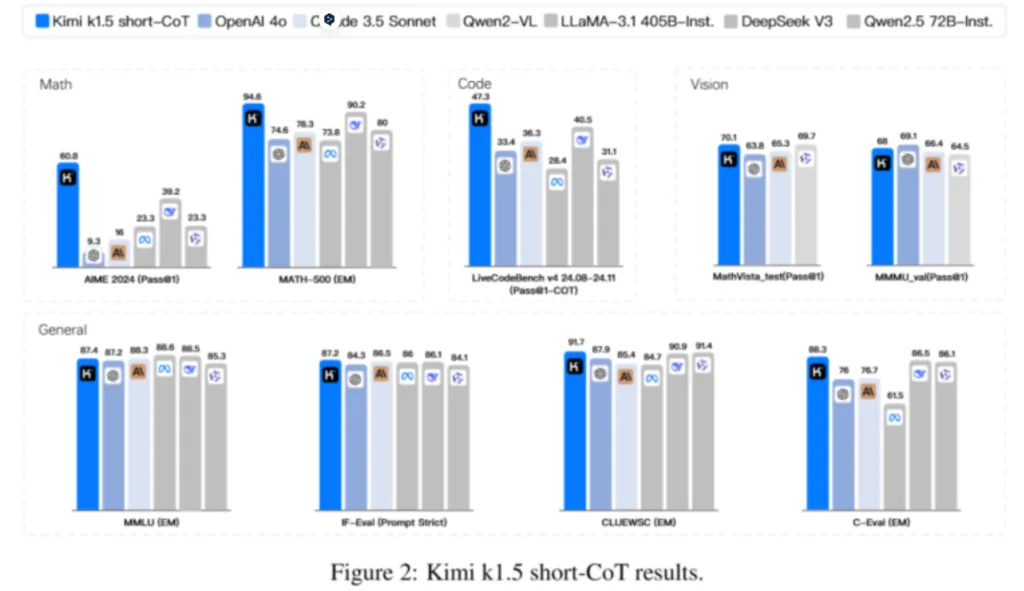

Компанія Moonshot AI розробила дві версії Kimi k1.5 – одну для докладних міркувань (long-CoT), а іншу для коротких відповідей (short-CoT). Згідно з технічним звітом компанії, обидві версії відповідають або перевершують за продуктивністю провідні моделі, такі як o1 і DeepSeek-R1 від OpenAI. Версія long-CoT крок за кроком описує хід своїх думок, а версія short-CoT прагне до стислості. У кількох тестах він показав такі ж або вищі результати, ніж GPT-4o і Claude 3.5 Sonnet.

На відміну від DeepSeek-R1, Kimi k1.5 може обробляти як текст, так і зображення, що дозволяє йому робити висновки на основі різних типів вхідних даних. Модель особливо добре справляється з мультимодальними тестами, такими як MathVista і MMMU. Однак, як і у випадку з усіма AI-моделями, реальна продуктивність може відрізнятися від результатів тестів.

Однак, як і завжди, ще належить з’ясувати, наскільки ця модель корисна на практиці за межами контрольних показників.

Розробка почалася з попереднього навчання моделі на великих текстових і графічних даних для створення базового розуміння мови та зображень. Потім команда зробила тонке налаштування, використовуючи ретельно відібрані невеликі набори даних. Для завдань з ясними відповідями, як у математиці, вони застосовували метод «відсіювальної вибірки», залишаючи тільки правильні відповіді. Також було створено навчальні матеріали з докладними покроковими поясненнями.

На заключному етапі використовували навчання з підкріпленням із фокусом на кінцевий результат, що дало моделі більше свободи в пошуку рішень. Щоб зробити відповіді ефективними, вводився штраф за зайву довжину.

Цей метод відрізняється від моделей R-1 і R-1-Zero компанії DeepSeek. R-1 використовує базове навчання з підкріпленням і зворотним зв’язком, а R-1-Zero – мінімалістичний підхід без додаткових даних.

Для підвищення ефективності міркувань команда знайшла способи передавати знання моделям, що генерують більш короткі відповіді, комбінуючи моделі і використовуючи метод «найкоротшої вибірки з відхиленням». Вони також з’ясували, що збільшення довжини контексту до 128 тисяч токенів покращує продуктивність без необхідності складних компонентів, таких як пошук по дереву Монте-Карло.

Moonshot AI, заснована 2023 року, швидко зросла, отримавши понад 1 мільярд доларів інвестицій від Alibaba до лютого 2024 року й оцінку в 2,5 мільярда доларів. До серпня оцінка досягла 3,3 мільярда доларів завдяки інвестиціям від Tencent і Gaorong Capital. Хоча Kimi k1.5 планується як конкурент ChatGPT, компанія поки що не зробила модель доступною для широкої публіки.