Microsoft представила новий інструмент у сервісі Azure AI Content Safety. Він призначений для виявлення і виправлення галюцинацій у контенті, згенерованому ШІ.

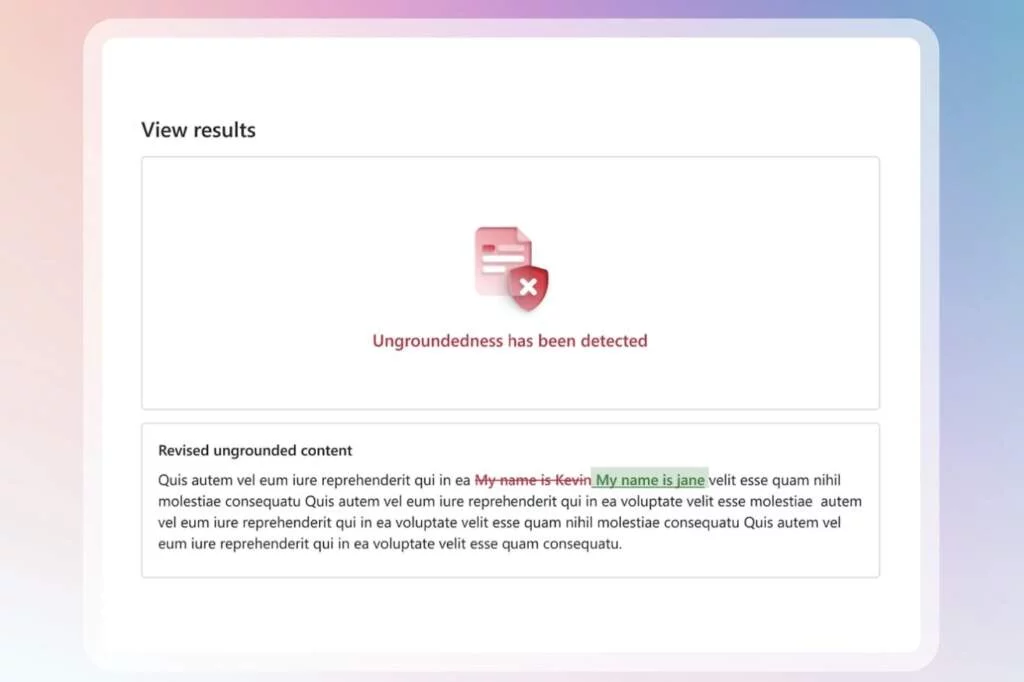

У Microsoft зазначають, що великі мовні моделі можуть видавати в результатах неточну або таку, що не відповідає дійсності, інформацію (галюцинувати). Новий інструмент визначатиме, чи ґрунтуються відповіді нейромережі на обраних користувачем вихідних матеріалах і ресурсах, і знаходитиме галюцинації. Microsoft також представила попередню версію можливості виправлення галюцинацій. Ось як вона працює:

- розробник програми вмикає функцію виправлення;

- у разі виявлення інформації, яка не відповідає даним у ресурсі, інструмент виділяє її у відповіді та надсилає в модель ШІ новий запит для виправлення;

- модель порівнює сумнівну інформацію з наданими їй ресурсами та переписує її.

Microsoft також анонсувала загальнодоступну попередню версію гібридної Azure AI Content Safety (AACS), яку можна запускати в хмарі та на пристрої. Нарешті, компанія представила попередню версію інструменту Protected Materials Detection for Code, який призначений для роботи зі згенерованим кодом. Інструмент визначить, чи згенерувала LLM якийсь захищений код. Раніше ця функція була доступна тільки через службу Azure OpenAI.

Сервіс Azure AI Content Safety призначений для виявлення шкідливого контенту, створеного як ШІ, так і користувачами. Він пропонує текстові та графічні API, що дає змогу розробникам ідентифікувати небажані матеріали.